Le macchine possono pensare, come gli aerei possono volare. Prima che gli aerei volassero, nessuno credeva che gli aerei potessero volare.

Questa la risposta del chatterBot Eloisa – una delle intelligenze artificiali diffuse su internet in grado di sostenere conversazioni – alla domanda che si pose Alan Turing (le macchine possono pensare?) quando concepì e realizzò la macchina che porta il suo nome.

Stando alla più che discutibile risposta di un chatterbot sarebbe solo questione di tempo: in futuro potremmo avere a che fare con dei robot pensanti.

C’è da chiedersi cosa significhi questo. Cosa si intende per robot pensante? Un robot potrà mai replicare capacità e caratteristiche esclusivamente umane, come l’autocoscienza?

Una cosa è certa: i computer già ora ci battono a scacchi. L’11 Maggio 1997 Deep Blue si prese la rivincita su Garry Kasparov in 6 partite, aggiudicandosi la vittoria per 3.5 a 2.5. Certo, fu in parte riprogrammato per evitare di cadere in alcune trappole dell’avversario, ma vinse, con buona pace di Kasparov.

Il punto però è: che grado di consapevolezza aveva Deep Blue? Si può dire che pensasse? O eseguiva solo una serie di calcoli? E quanto è sottile la differenza fra i due concetti? Non si può rispondere alla domanda se non si stabilisce quando una macchina possa dirsi pensante.

Un primo criterio di intelligenza lo stabilì Turing con la formulazione del celebre test. Supponiamo di trovarci davanti un terminale e di porre delle domande scrivendole su una tastiera; dall’altro capo del terminale vi sono un computer e un essere umano, che forniscono alternativamente le risposte alle domande. L’ipotesi è che se non siamo in grado di distinguere la macchina dall’essere umano, allora la macchina è intelligente.

Finora nessuna intelligenza artificiale ha superato il test. Ma quand’anche venisse superato, è opportuno chiedersi se questo implicherebbe un pensiero cosciente della macchina. In caso di positività al test, ci troveremmo forse di fronte a una sorta di HAL 9000, capace di possedere un pensiero autonomo e autocosciente, tanto da arrivare a temere per la propria sopravvivenza? Niente di tutto questo, anzi molto meno, come dimostra l’esperimento mentale che segue. Poniamo che esista un computer che superi brillantemente il test di Turing e che questo computer sia in grado di rispondere a qualsiasi domanda posta in lingua cinese. Ora immaginiamo di nuovo la situazione del test. Stavolta a porre le domande c’è una persona di lingua madre cinese, il quale scrive delle domande su una tastiera e riceve delle risposte alternativamente dal computer e dall’operatore umano. Il cinese sarebbe allora portato a pensare che i suoi interlocutori – in particolare l’umano – conoscano il mandarino. Invece, con sua sorpresa, scopre che l’operatore non solo non conosce il mandarino, ma non ha mai visto un ideogramma in vita sua: ha solo eseguito una serie di istruzioni. Per analogia, allora, neanche il computer è in grado di capire ciò che risponde, o perlomeno non è detto che capisca.

Il filosofo John Searle ideò questo esperimento (de La Stanza Cinese, appunto) per contrapporsi alla tesi dell’IA forte, secondo la quale se un computer risulta indistinguibile da un essere umano, allora anche la sua intelligenza è indistinta. A ben vedere, Searle ha dimostrato che il test di Turing non riesce a dimostrare neanche l’intelligenza di un essere che sappiamo essere intelligente, vale a dire noi. L’esperimento peraltro è stato condotto personalmente da Marcus du Sautoy (l’Enigma dei numeri primi, Il disordine perfetto) nel documentario The Hunt for AI: il professore riesce a rispondere in modo impeccabile a una ragazza cinese senza avere la minima idea di cosa stia scrivendo.

Abbiamo fatto fuori il test di Turing. E scusate se è poco.

In mancanza di un criterio migliore, dobbiamo scendere nel profondo e chiederci quale sia il discriminante fra la nostra intelligenza e quella automatica, e in cosa consista. A ben vedere, per far questo dobbiamo chiederci in cosa consista la nostra intelligenza. E’ più ragionevole credere che sia una caratteristica circoscritta o piuttosto un processo, un iter di apprendimento che porta alla consapevolezza del mondo esterno e di se stessi? Qualora fosse il risultato di un apprendimento, si scopre più interessante il quesito di partenza: in cosa consiste il processo di apprendimento umano e quali sono le caratteristiche che potrebbero renderlo, o meno, implementabile?

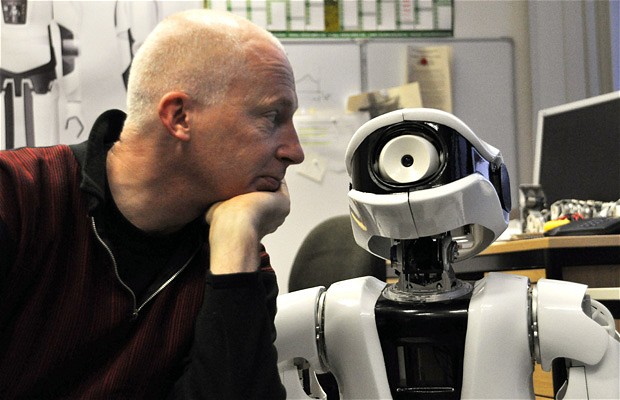

Forse una delle risposte sta nel nostro corpo: è la tesi del Prof. Owen Holland che lavora allo sviluppo di robot antropomimici.

Dice Marcus du Sautoy nel documentario “The Hunt for AI”:

(Il Prof. Holland) crede che la nostra conformazione fisica dia forma al modo in cui pensiamo. E senza un corpo, l’intelligenza artificiale non potrebbe esistere. Questo robot evidentemente non ha sangue, pelle o carne, ma ha ossa, giunture, muscoli e tendini, che si muovono esattamente come i nostri. Perciò è in grado di avere delle interazioni col mondo simili a quelle umane.

E, dopo aver stretto la mano a ECCEROBOT (il polifemico robot antropomimico) continua così, alzando ancora l’asticella della discussione – come se già non si parlasse di cose al limite della fantascienza:

– [MdS] Per quanto riguarda l’obiettivo finale di cose come l’immaginazione e la coscienza, questi robot potrebbero effettivamente diventare consapevoli del proprio corpo?

– [Prof. Holland] Be’ credo davvero che sia la questione più interessante di tutte, ma ci sono molti problemi da superare prima di arrivare a quella fase. Penso che un giorno sarà possibile costruire una macchina che abbia una sorta di coscienza. Che si tratti del nostro stesso tipo di coscienza, qualunque cosa significhi, sarà un problema. Ma credo che sia la strada giusta. Non credo proprio che arriveremo a una coscienza con un computer senza corpo.

Sembrerebbe quindi che l’AI del futuro assomigli più ad Ash di Alien che non a Deep Thought di Guida Galattica per autostoppisti.

Questa, e una serie di altre questioni, affronta in modo quanto più possibile scientifico La mente nuova dell’Imperatore, saggio colossale di Roger Penrose – matematico e fisico noto per la sua collaborazione (e per le sue scommesse, vinte) col più celebre Stephen Hawking. Dice Penrose nell’introduzione:

Che cosa significa pensare o sentire? Che cos’è una mente? Le menti esistono davvero? Supponendo che esistano, in quale misura sono funzionalmente dipendenti dalle strutture fisiche a cui sono associate? Potrebbe una mente essere indipendente da una tale struttura? Oppure le menti sono semplicemente il funzionamento di (tipi appropriati di) strutture fisiche? In ogni caso, è necessario che le strutture pertinenti siano di natura biologica (cervelli), o le menti potrebbero essere associate altrettanto bene a dispositivi elettronici? Le menti sono soggette alle leggi della fisica? E cosa sono di fatto, le leggi della fisica?

Sono quasi seicento pagine, e vale la pena – considerata la penna – affrontarle tutte.

Al prossimo appuntamento.